1. Etcd冷启动

1.1 初始化主流程

Etcd的启动类为 父目录的main.go文件。其启动过程调用如下:

1 | main.go |

startEtcd中执行etcd启动的主要过程:

1 | embed.startEtcd(inCfg *Config) |

通过 cfg.PeerURLsMapAndToken(“etcd”) 逻辑,了解到etcd有三种方式来获取集群中其他节点信息:

1 | switch { |

准备好创建etcd节点后开始初始化节点信息:

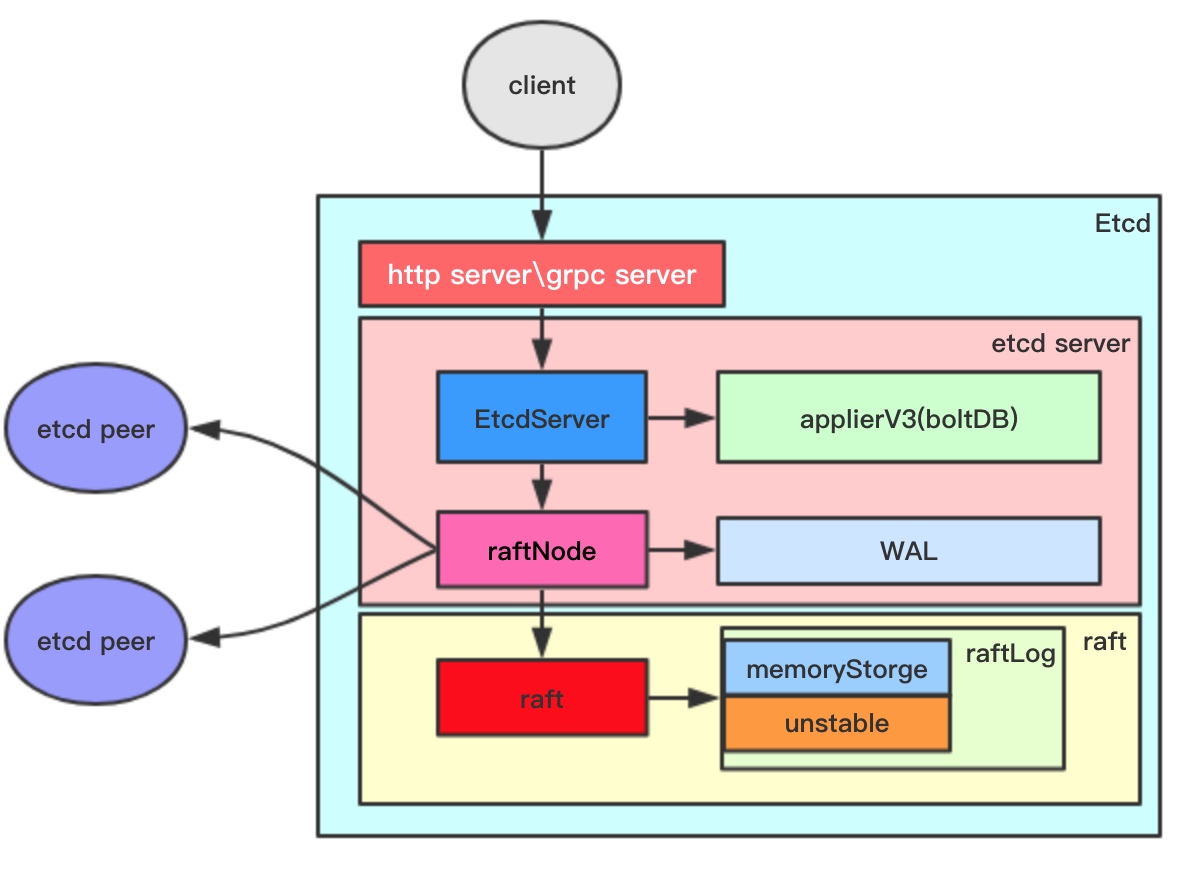

1 | etcdserver/NewServer(srvcfg) |